cta

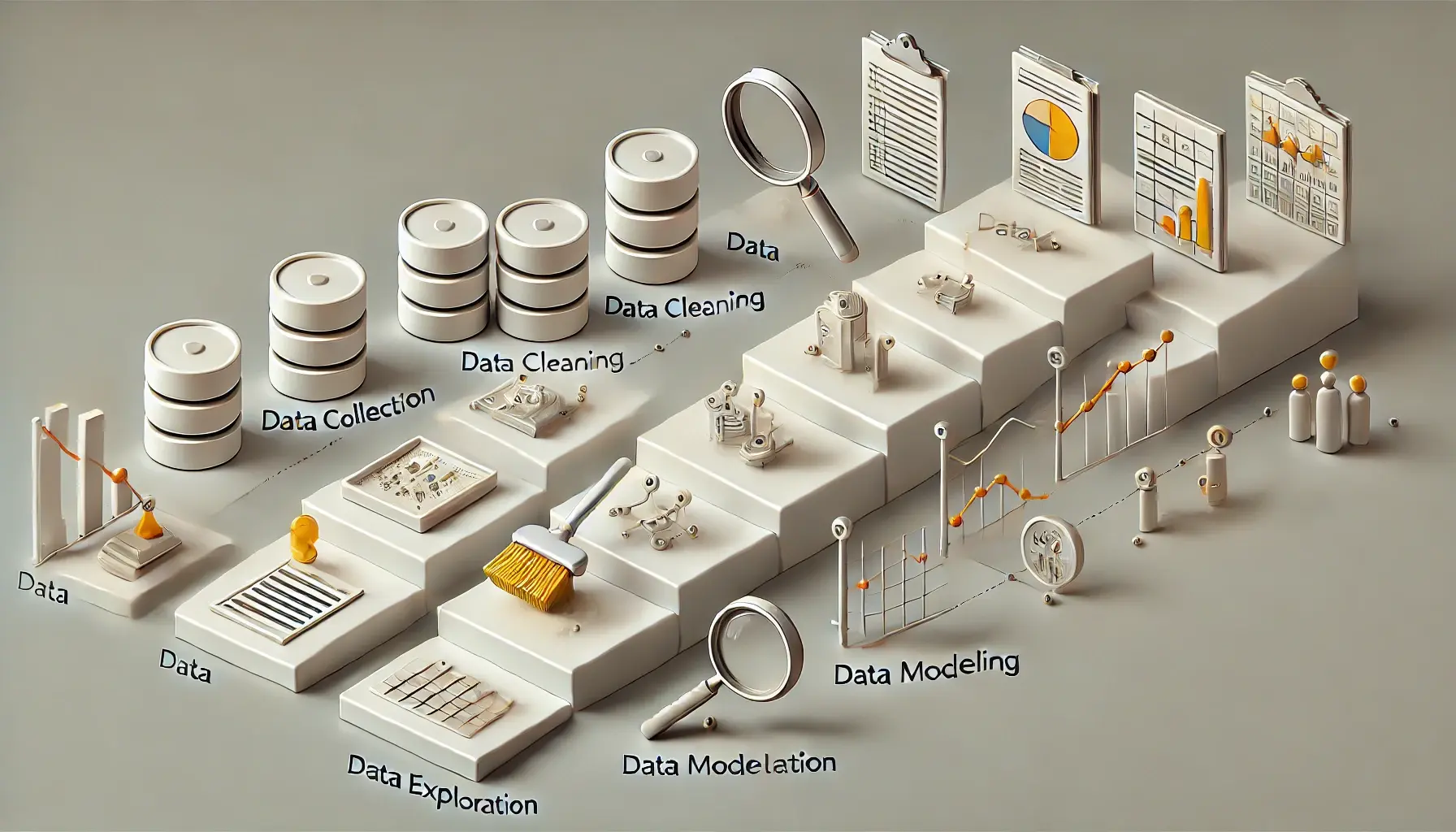

データ分析の基本手順

ステップ1:問題の定義

データ分析のプロセスを開始する際に最も重要なステップは、「問題の定義」です。この段階で明確に問題を特定し、分析の目的を設定することが成功への鍵となります。具体的に何を解決または理解しようとしているのかをはっきりさせることで、その後の分析作業がスムーズに進行します。

なぜ問題の定義が重要なのか?

-

方向性の確立: 明確な問題定義は、分析の方向性を決定づけます。何を知りたいのか、どういう情報が必要かを明らかにすることで、必要なデータを選定しやすくなります。

-

リソースの最適化: 分析に必要なリソース(時間、人的資源、技術)を適切に配分するためには、目的が明確でなければなりません。これにより、効率的にプロジェクトを進めることができます。

-

成果の測定: 分析の目的が具体的であればあるほど、その成果を測定しやすくなります。目標が明確な場合、達成度を測定する基準も明確に設定できるため、プロジェクトの成功を具体的に評価することが可能です。

問題の定義の具体的な方法

問題の定義を行う際には、以下のステップに従うことが推奨されます。

-

ステークホルダーとの協議: プロジェクトに関わるステークホルダー(クライアント、管理者、エンドユーザーなど)との初期ミーティングを設け、彼らが何を期待しているかを理解します。

-

問題の特定: 議論を通じて、具体的な問題点や改善点をリストアップします。

-

目標の設定: 特定された問題に対して、達成したい具体的な目標を設定します。これには量的な目標や質的な目標が含まれることがあります。

-

仮説の立案: 分析に先立ち、仮説を立てます。これは、予想される結果や解決策を形式化したものです。

この「問題の定義」の段階を丁寧に行うことで、データ分析プロジェクト全体の効果を最大限に高めることが可能になります。問題が明確でないと、分析は方向性を失いがちですので、この初期段階を慎重に進めることが不可欠です。

ステップ2:データの収集

データ分析の次の重要なステップは、「データの収集」です。この段階では、問題の定義で設定した目標に基づき、必要なデータを集めます。データ収集の方法は、プロジェクトの種類や利用可能なリソース、データのアクセシビリティによって異なります。

データ収集の主な方法

-

プライマリデータ収集:

-

調査: アンケートやインタビューを通じて直接情報を収集します。ターゲットとする対象から直接意見や行動を記録します。

-

実験: 条件を変えながらデータを収集し、因果関係を探求します。

-

-

セカンダリデータ収集:

-

既存のデータベース: 政府統計、企業の財務報告、既に公開されている研究データなど、他者がすでに収集・公開しているデータを利用します。

-

オンライン情報: ウェブサイトやソーシャルメディアから情報を収集することができます。

-

データ収集の計画

データ収集を効率的に行うためには、事前に計画を立てることが重要です。計画には以下の要素が含まれるべきです。

-

データの種類と形式の特定: 収集するデータが数値データ、カテゴリデータ、テキストデータのどれに該当するかを明確にし、データの形式(例:CSV、Excel、APIを通じたデータ等)も考慮に入れます。

-

データソースの特定: データをどこから、どのように収集するかの具体的な方法を計画します。

-

データ収集のタイムライン: プロジェクトのスケジュールに合わせて、データ収集の開始と終了の時期を設定します。

データ収集の課題と対策

データ収集の過程では多くの課題が生じることがあります。例えば、データの不完全性、アクセスの困難さ、品質の問題などが挙げられます。これらの課題に対処するためには、次のような対策が有効です。

-

データの品質を確認: 収集したデータの品質を確認し、必要に応じてクレンジングや補正を行います。

-

データのセキュリティを確保: 収集したデータのセキュリティを確保し、プライバシーを守るための措置を講じます。

このようにデータ収集は、データ分析の基礎を築く重要なプロセスです。適切なデータ収集方法を選択し、計画的に進めることで、分析の質と効率を大きく向上させることができます。

ステップ3:データの前処理

データの前処理は、データ分析のプロセスにおいて極めて重要なステップです。この段階では、収集したデータを分析に適した形に整理・変換します。適切に前処理を行うことで、データの質が向上し、分析の精度と効率が大幅に改善されます。

データのクリーニング

データのクリーニングは、データセットから不正確、欠損、または異常なデータを特定し、修正または削除するプロセスです。具体的な手順には以下のようなものがあります。

-

欠損値の処理: 欠損値を削除するか、平均値、中央値、最頻値などで補完します。

-

外れ値の識別と対応: 統計的手法を用いてデータセットの外れ値を識別し、適切に処理します。外れ値を削除するか、他の値で置換するかは、そのデータの重要性に応じて決定します。

-

データの整合性の確認: データセット内の重複や矛盾を解消し、データの一貫性を保ちます。

データの変換

データの変換は、データを分析しやすい形式に変更するプロセスです。このプロセスには以下のような活動が含まれます。

-

正規化と標準化: 数値データを特定の範囲や平均と標準偏差に基づいて調整します。これにより、異なるスケールのデータを比較可能にします。

-

カテゴリデータのエンコーディング: 文字列で表されるカテゴリデータを数値化します。例えば、ワンホットエンコーディングやラベルエンコーディングがあります。

-

データのタイプ変換: データタイプを変更して、分析ツールが適切に処理できるようにします(例:日付データのフォーマット変更や数値データへの変換)。

データの統合

異なるソースから収集したデータを統合することで、より完全で包括的なデータセットを作成します。データ統合は、異なるデータベースやファイル形式のデータを一つのデータセットに統合することを含みます。

データの前処理を適切に実施することは、分析の正確性を保証し、後続のデータ探索や分析作業を効率的に進めるための基盤を築きます。この段階を丁寧に行うことで、データ分析の質が大きく向上し、信頼性の高い結果を得ることができます。

ステップ4:データの探索

データの探索(Exploratory Data Analysis, EDA)は、前処理を経たデータに対して実施する解析の初期段階です。この段階では、データをさまざまな角度から観察し、潜在的なパターン、異常、洞察を抽出することが目的です。データの探索を通じて、より複雑な分析の方向性を見定めることができます。

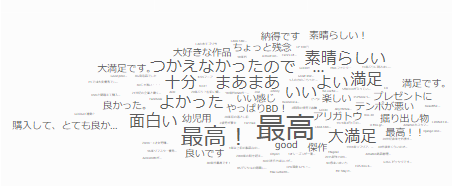

データの可視化

データの探索では、可視化が非常に重要な役割を担います。以下のような可視化手法が一般的です。

-

ヒストグラム: データの分布を視覚化します。特にデータの偏りや分散の度合いを把握するのに有効です。

-

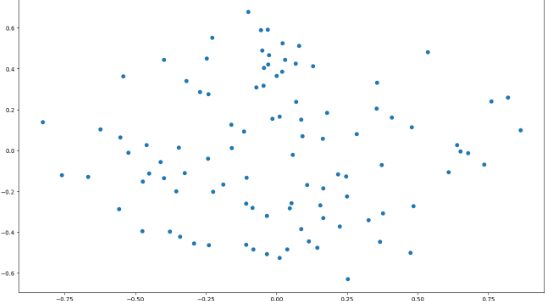

散布図: 二つの変数間の関係を点で表し、相関関係を探ります。

-

箱ひげ図(ボックスプロット): データの中央値、四分位数、外れ値を視覚的に表現します。

-

棒グラフ: カテゴリに基づくデータの量を比較します。

これらの可視化手法により、データの基本的な特性や潜在的な問題点が明らかになります。

基本統計の分析

データの探索には、基本的な統計量の計算も含まれます。これには平均値、中央値、モード、標準偏差、分散などがあります。これらの統計量は、データの傾向と変動を理解するための基礎となります。

-

平均値と中央値: データの中心傾向を示します。

-

標準偏差と分散: データがどれだけ散らばっているかを示します。

-

相関係数: 二つの変数間の直線的な関係の強さを示します。

多変量解析

複数の変数を同時に分析することで、変数間の複雑な関係や、影響を与える因子を探ります。多変量解析には、主成分分析(PCA)、クラスター分析、因子分析などがあります。

-

主成分分析(PCA): 多次元のデータを主要な成分に圧縮して、データの構造を簡略化します。

-

クラスター分析: 類似した特性を持つデータポイントをグループ化し、データ内の自然なクラスターを識別します。

データの探索を通じて得られた洞察は、データ分析プロジェクトの次のステップ、すなわちデータの深い分析に向けた仮説設定や分析計画の策定に直接寄与します。この段階を丁寧に行うことで、分析の方向性がより明確になり、有効な結果を得る確率が高まります。

ステップ5:データの分析

データの探索を終えた後、データ分析のプロセスでは具体的な分析手法を適用してデータから意味ある情報を抽出します。この段階では、問題の定義で設定した目標に基づいて、適切な統計的手法や機械学習アルゴリズムを用いてデータを解析します。

統計的手法の適用

データに対する統計的アプローチは、単純な記述統計から始まり、推測統計へと進むことが一般的です。以下の手法が広く利用されます。

-

回帰分析: 一つまたは複数の予測変数(独立変数)と結果変数(従属変数)との関係をモデリングします。線形回帰、ロジスティック回帰などがあります。

-

分散分析 (ANOVA): 三つ以上のグループ間でのデータの平均値が統計学的に異なるかどうかをテストします。

-

クラスター分析: 似た特性を持つデータポイントをグループ化し、データセット内のパターンを識別します。

機械学習モデルの構築

問題に応じて、以下のような機械学習アルゴリズムが利用されることがあります。

-

教師あり学習: ラベル付きデータを使用して、入力データから出力データ(目的変数)を予測するモデルを訓練します。分類と回帰が主なタスクです。

-

教師なし学習: ラベルのないデータを使用して、データセット内の構造や関係を見つけ出します。クラスタリングや次元削減が一般的です。

-

強化学習: エージェントが環境内で最適な行動を学習することで、最大の報酬を得るように訓練されます。

モデル評価と選択

分析モデルを構築した後、その性能を評価し、問題解決に最も適したモデルを選択する必要があります。モデル評価には、交差検証、ROC曲線、混同行列などが使用されます。これにより、モデルの一般化能力と適合度を判断できます。

-

適合度の評価: モデルが訓練データにどれだけよく適合しているかを評価します。

-

予測性能の検証: 新しい、未知のデータに対するモデルの予測性能を検証します。

データ分析のこの段階では、適切なモデルの選択と精度の高い予測が重要です。ここでの洞察が、最終的な結果の解釈と報告の基盤となり、実際の意思決定プロセスに影響を与えるため、慎重な分析が求められます。

ステップ6:結果の解釈と報告

データ分析プロセスの最終段階である「結果の解釈と報告」は、分析結果を意味ある洞察に変換し、それを関係者に効果的に伝えるための手段です。この段階は、プロジェクトの目的に基づいた意思決定をサポートするため、特に重要です。

結果の解釈

結果を解釈する際には、分析の目的と設定した仮説を基にして、データから得られた知見を評価します。以下の点を考慮することが重要です。

-

結果の妥当性: 分析結果が統計的に有意かどうかを検証し、モデルの信頼性を評価します。

-

影響因子の識別: 結果に最も大きな影響を与えた変数や条件を特定します。

-

予期せぬ発見: 分析中に予期しなかったパターンやトレンドが見つかった場合、その意味や可能性について掘り下げます。

報告書の作成

結果の報告は、データ分析の成果を共有し、実行可能な提案を提示するために行います。報告書は以下の要素を含むべきです。

-

概要: 分析の目的と主要な結果を簡潔に説明します。

-

方法論: 使用したデータセットと分析手法について詳述します。

-

主要な発見: 分析から得られた主要な洞察とその統計的な裏付けを提示します。

-

推奨事項: 分析結果に基づいた具体的な行動提案を行います。

-

視覚的要素: グラフ、チャート、表を使用して、データの洞察を視覚的に表現し、理解を助けます。

プレゼンテーションの準備

最終的な成果をステークホルダーに効果的に伝えるためには、プレゼンテーションが不可欠です。プレゼンテーションでは、次の点を考慮することが重要です。

-

聴衆の理解度: 聴衆の専門知識や関心に合わせて情報の深さを調整します。

-

ストーリーテリング: データと分析の流れを物語性を持って伝え、聴衆の関心を引きつけます。

-

対話の促進: 質問やディスカッションの時間を設け、フィードバックを受け取ることで、報告の内容をさらに深める機会を作ります。

結果の解釈と報告は、データ分析プロジェクトを締めくくる重要なステップです。ここでの成果がプロジェクトの成功を大きく左右し、実際の意思決定や施策の実行に直結します。適切にこの段階を実行することで、データの価値を最大限に活用することができます。

データ分析を進める上で注意すべきポイント

データ分析を行う際には、精度の高い結果を得るためにいくつかの重要なポイントに注意する必要があります。これらのポイントは、プロジェクトの成否を左右するため、事前に理解し対策を講じておくことが推奨されます。

データの品質の確保

-

完全性: 使用するデータが完全であることを確認します。欠損データや異常値が分析結果に影響を与えないよう、適切に処理する必要があります。

-

正確性: データが正確であることを保証するため、データソースの信頼性とデータ収集方法に注意を払うことが重要です。

-

一貫性: 異なるソースから得たデータが互いに矛盾しないように、一貫性を確保するための検証作業が必要です。

分析手法の選択

-

適切な手法の選択: 解決しようとしている問題に最適な分析手法を選択することが重要です。手法が問題に適していない場合、誤った洞察や結果を導くことになりかねません。

-

手法の理解: 使用する統計的手法や機械学習アルゴリズムの背後にある理論と仮定を十分に理解することが必要です。これにより、結果の解釈時に誤解を避けることができます。

ステークホルダーとのコミュニケーション

-

期待値の調整: ステークホルダーに対して、分析の目的、可能性、および限界を明確に説明することが重要です。これにより、リアリスティックな期待値が設定され、プロジェクトの進行におけるサポートが得やすくなります。

-

進捗の共有: 分析プロジェクトの進捗を定期的に報告し、必要なフィードバックを受け取ることで、プロジェクトの方向性を適切に調整できます。

法的および倫理的考慮

-

データプライバシー: 個人データを扱う際には、適用されるデータ保護法規(例えばGDPRやCCPAなど)を遵守する必要があります。データの匿名化やセキュリティ対策を適切に行うことが求められます。

-

倫理的な使用: データと分析結果を倫理的に利用することが求められます。特にバイアスのあるデータや分析結果が社会的に不公平な影響を及ぼさないように注意が必要です。

データ分析を成功させるためには、これらのポイントに留意し、計画的かつ慎重にプロジェクトを進めることが不可欠です。正しい準備と適切な手順が、信頼性の高い結果と有効な洞察をもたらす鍵となります。

おすすめのデータ分析ツール

データ分析を効果的に行うためには、適切なツールの選択が非常に重要です。以下では、初心者から上級者まで幅広く使用されているデータ分析ツールを紹介します。これらのツールは、データの収集、前処理、探索、分析、結果の報告までの全プロセスをサポートします。

プログラミング言語ベースのツール

-

Python: Pythonは、その豊富なライブラリ(Pandas、NumPy、SciPy、Matplotlib、Seaborn、Scikit-learn)により、データ分析の分野で最も人気のある選択肢の一つです。機械学習プロジェクトにも広く使われています。

-

R: Rは統計分析とデータ可視化に特化したプログラミング言語で、高度な統計解析が求められる学術研究において特に重宝されます。ggplot2やdplyrといったパッケージがデータ分析を容易にします。

GUIベースのツール

-

Tableau: データの視覚化に特化したツールで、ドラッグアンドドロップのインターフェースを通じて複雑なデータセットから直感的なダッシュボードとレポートを生成できます。非技術者にも使いやすく設計されています。

-

Power BI: Microsoftが提供するビジネスインテリジェンスツールで、Excelとの親和性が高く、データ集約、分析、共有がこのプラットフォーム上でスムーズに行えます。

オープンソースツール

-

KNIME: データパイプラインの設計と分析を行うのに適した、オープンソースのデータ分析ツールです。ノードと呼ばれるブロックを組み合わせることで、データの前処理から機械学習モデルのデプロイまでをグラフィカルに構築できます。

-

Jupyter Notebook: PythonやRなどのコードをブラウザ上で実行し、コード、グラフィックス、説明テキストを一つのドキュメントに統合できるツールです。分析結果の共有や再現性のある研究に最適です。

企業向けエンタープライズツール

-

SAS: 大企業や高度な分析が求められる業界で広く利用されている強力な分析ソフトウェアです。信頼性の高いデータ管理機能と高度な分析機能を提供します。

-

SPSS: 統計分析を主としたソフトウェアで、社会科学分野などで広く用いられています。直感的なインターフェースと豊富な統計機能が特徴です。

これらのツールはそれぞれ独自の強みを持ち、プロジェクトのニーズやチームのスキルレベルに応じて最適なものを選択することが重要です。各ツールの提供する機能、利便性、コストを考慮して選択し、データ分析プロジェクトの成功に繋げましょう。

まとめ

本記事では、データ分析の全過程を網羅的に解説しました。データ分析の成功には、明確な問題定義から始まり、適切なデータの収集、前処理、探索、具体的な分析手法の適用、そして最終的な結果の解釈と報告まで、一連のステップが重要です。また、分析過程でのポイントとして、データの品質、適切なツールの選択、法的倫理的な考慮が必要です。このガイドラインを参考にしながら、効率的かつ効果的なデータ分析を実行していくことができます。

cta